星云Clustar首席科学家胡水海应邀出席HPC-AI论坛发表演讲

商业 来源: 2020/9/30 4:37:17 阅读:1464

第十六届高性能计算峰会(简称CCF HPC CHINA 2020)于9月28日-30日线上线下同步召开。星云Clustar首席科学家胡水海受邀在HPC-AI论坛发表“高性能联邦机器学习异构系统”主题演讲。

CCF HPC CHINA 2020是全球高性能计算领域最具影响力的三大盛会之一,大会旨在通过汇聚前沿学术成果、展示创新应用技术、交流创造行业价值,促进超算技术应用生态与产业数字化升级转型,打造一个全球化开放式HPC交流共享平台。

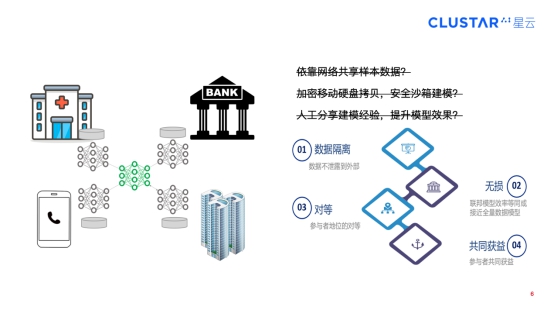

众所周知,AI领域目前存在比较严重的数据孤岛问题。虽然每个机构都有数据,但这些数据是互相割裂的,相互之间并不能连接。胡水海在演讲中表示,“随着国内外针对各领域数据安全和用户隐私保护的法律密集出台,直接聚合多方原始数据进行使用的行为被明令禁止,这使得数据形成一个个孤岛,而联邦学习的出现为打破数据孤岛提供了一个好的方案。有了联邦学习,无论是医院、银行或其他企业组织机构、还是个人的终端设备,在联合发挥数据价值时,可以不用交换存储在本地的原始数据,只需要通过模型相互学习即可得到与全量数据模型一样的结果。”

联邦学习连接数据孤岛

实现联邦学习这种神奇效果的关键技术是同态加密计算,即直接对密文进行处理,得到的结果仍然是加密的,且对密文直接进行处理,解密后跟对明文进行处理后的结果相同,其使用范围非常广,显著的缺陷就是性能太低,目前通常采用部分同态加密这种性能勉强能接受的折中方式,但计算量依然是明文计算量的上百倍,且数据传输总量也比传统机器学习大100到1000倍。

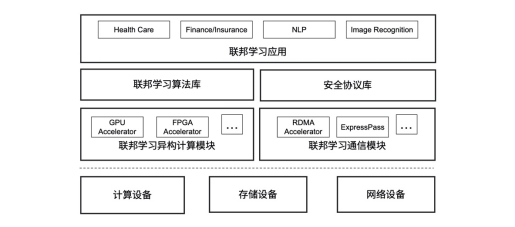

面对巨大的密文计算量和传输量挑战,胡水海提到了星云Clustar设计的一种高性能联邦机器学习异构系统,“这个系统最上层是应用层,通过调用下面的联邦学习算法库和安全协议库,开发者可以在上面开发各种联邦学习应用。在这之下,我们有两个模块用来指出联邦学习高性能计算和通信,包括联邦学习异构计算模块和联邦学习通信模块。联邦学习异构计算模块可以支持使用各类异构硬件,包括GPU、FPGA、专用ASIC芯片等,来加速联邦学习中的安全计算。联邦学习通信模块主要使用RDMA高性能网络以及一些专门设计的网络技术来加速联邦学习数据传输。

高性能联邦机器学习异构系统设计框架图

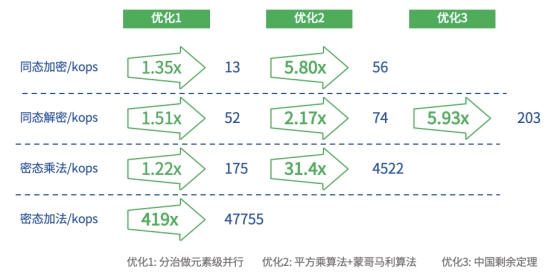

胡水海还表示,异构计算适合加速高度并行、重复的轻量级、批量化海量数据、密集型计算任务,因此非常适合联邦学习加速,但同时也面临异构计算硬件通常不直接支持大整数运算、涉及大量的模幂运算、高速缓存非常有限等挑战。基于此,星云Clustar设计了基于分治思想做元素级并行、平方乘算法 + 蒙哥马利算法、中国剩余定理减小中间计算结果3种优化手段来最大化异构硬件对联邦学习计算的加速。经过三种优化手段后,GPU为联邦学习带来了差不多6倍的加速比,对于计算相对简单的密态乘法和密态加法,GPU为联邦学习分别带来了30倍以上和400倍以上的加速比。

异构加速联邦学习评测结果 – GPU vs CPU

最后,胡水海介绍了星云Clustar面向数据中心内部不同机构间通信和不同机构的数据中心跨区域通信两大场景的探索成果,“针对数据中心内场景,我们采用的解决方案是通过RDMA网络技术优化两点间通信,然后通过动态参数聚合模型优化多点间通信加速联邦学习通信。对于跨区域通信场景,我们在探索设计一种机器学习专用的网络传输协议,在高延迟、高丢包率网络环境下加速联邦学习通信。”

近年来,联邦学习技术作为有效解决数据孤岛分布问题的主流技术之一备受关注,联邦机器学习异构系统为解决联邦学习计算与传输问题提供了新的技术思路。星云Clustar作为国内率先开展隐私计算技术实现与应用探索的公司,未来将继续以高性能网络和联邦学习技术助力人工智能产业发展与技术突破,深掘联邦学习落地场景的可能性,推进联邦学习带来的技术红利落地于各行业领域,帮助企业与机构的多方数据安全合作更具可得性。